LLYC lanza herramienta de IA para detectar sesgos en noticias sobre violencia de género para mejorar información

The Purple Check, es el nombre de la herramienta, la cual comprueba si los titulares de las noticias tienen algún sesgo y en ese caso, recomienda cómo poder decir lo mismo sin promover la desigualdad

LLYC lanzó The Purple Check, una herramienta de inteligencia artificial que identifica sesgos en cómo se comunican hechos relacionados a violencia de género con el propósito de mejorar la información al respecto.

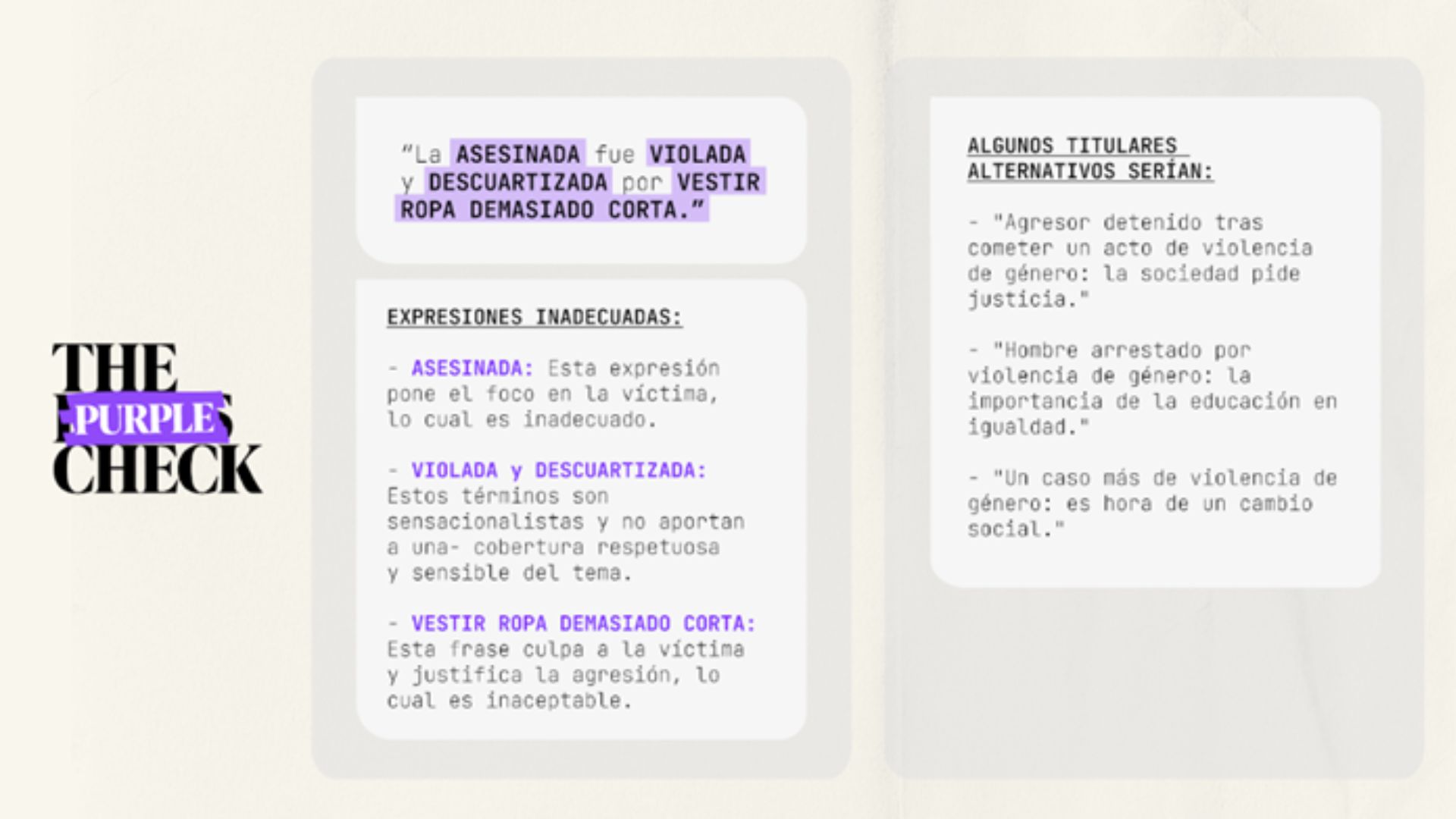

El instrumento funciona de forma sencilla: se introduce un titular y la solución comprueba si las palabras que hemos utilizado están en línea con las reglas de buenas prácticas derivadas de las guías United Nations Development Programme (UNDP) y Mediterranean Network of Regulatory Authorities (MNRA). En caso contrario, recomendará cómo decir lo mismo para informar sin promover la desigualdad y así devolver el foco a la comunicación.

The Purple Check es una herramienta de libre acceso dado que la lucha contra la violencia de género es un asunto que convoca a todos y que está en línea con la defensa de los Derechos Humanos.

“The Purple Check refleja nuestro compromiso con la igualdad. Es una contribución que hacemos desde la innovación y nuestra herramienta propia de IA para generar conciencia social. Necesitamos un tratamiento de la información más objetivo, equilibrado y justo. La solución nos permite enfocar las noticias con perspectiva de género. Sólo si todos detectamos el sesgo podemos conseguir que el lenguaje sea una herramienta más de cambio”, afirma Luisa García, Socia y COO Global de LLYC.

Aquí tienes un ejemplo de la alternativa que da The Purple Check a un titular que ha aparecido en un medio de comunicación:

The Purple Check surge a raíz de la elaboración del informe ‘Desenfocadas: Cómo opinar e informar mejor sobre la violencia de género’ que ha realizado LLYC en el marco del Día Internacional de la Mujer (8M).

El estudio, que contó con el uso de esta herramienta, analizó 226,2 millones de artículos de noticias generales, 5,4 millones de noticias sobre violencia de género y 14 millones de mensajes en la red social X relacionados con la violencia de género en 12 países en los que la consultora está presente (Argentina, Brasil, Chile, Colombia, Ecuador, España, Estados Unidos, México, Panamá, Perú, Portugal y República Dominicana).

En la investigación se han empleó Large Language Models (LLMs- GPT4) para identificar y aislar descriptores dirigidos a víctima y agresor, en noticias públicas obtenidas mediante modelos de scrapers, así como técnicas de Procesamiento de Lenguaje Natural (NLP) en 4 idiomas para analizar el cumplimiento de 21 reglas de buenas prácticas derivadas de las guías UNDP y MNRA.

La principal conclusión del estudio es que, aunque los medios de comunicación concientizan, sensibilizan y ayudan a prevenir la violencia de género el doble que las redes sociales, queda mucho trabajo por delante. Todavía el 20% de las noticias publicadas justifican las agresiones.

“Quienes participamos en la conversación social sabemos que dar visibilidad a la violencia de género es fundamental para avanzar en su erradicación. Sin embargo, hacerlo mal puede ser contraproducente, generando sensacionalismo y provocando una doble victimización. Desde LLYC queremos, no solo evidenciar este riesgo sino aportar herramientas para evitarlo”, concluye Luisa García.

Publicado 2024-03-05